PEMROSESAN TEKS DAN RELEVANSINYA DENGAN PENELITIAN SURVEI

Salah satu tugas penting yang dilakukan dalam survei penelitian adalah pengolahan teks-teks yang dikumpulkan, baik berupa teks repetitif pendek maupun teks opini panjang. Biasanya tugas ini dilakukan di perusahaan riset pasar oleh satu atau beberapa orang yang perannya dalam organisasi disebut CODER. Tugas pembuat kode (atau pengklasifikasi) adalah mengubah berbagai teks yang dikumpulkan menjadi kategori tertutup, seolah-olah ia adalah pertanyaan pilihan tunggal. Meskipun kelihatannya merupakan tugas yang sederhana, pembuat kode harus memiliki kapasitas intelektual dan heuristik serta intuisi untuk dapat mengklasifikasikan berbagai tanggapan ke dalam kategori tertutup yang mencakup dan mencerminkan pendapat responden.

PROSEDUR PENGKODEAN SURVEI TEKS OPINI

Saat mengklasifikasikan teks survei, pembuat kode harus membaca semua teks dengan cepat dan diagonal, atau setidaknya membuat sampel representatif dari teks yang dipilih secara acak. Misalnya, jika kita melakukan survei pada sampel 5.000 orang, membaca setiap tanggapan untuk mengetahui tema mana yang paling relevan dalam hal pengulangan dan frekuensi ide akan membutuhkan waktu yang sangat panjang dan tugas yang membuat frustrasi. Oleh karena itu, peneliti pertama-tama harus memilih kelompok teks acak yang dapat ditentukan oleh mata, seperti 100 teks. Setelah pembacaan diagonal cepat ini, pembuat kode harus menuliskan deskripsi umum dari apa yang telah dibacanya. Mencoba untuk memvisualisasikan kemungkinan kategori yang menjadi atribut teks-teks ini. Kemudian pembuat kode harus membaca setiap teks, satu per satu dan menempatkannya di dalam salah satu kategori tertutup yang awalnya divisualisasikan. Jika teks yang dibaca tidak termasuk dalam kategori mana pun, maka perlu membuat kategori baru untuk menempatkannya.

MASALAH YANG DITEMUKAN DALAM SURVEI DENGAN PENGOLAHAN TEKS

Ada banyak masalah dan kerugian terkait dengan pengkodean teks manual yang dijelaskan pada paragraf sebelumnya. Yang pertama adalah penanganan sejumlah besar data yang dikumpulkan dalam survei. Masalah ini dapat dikurangi dengan menggabungkan beberapa orang untuk bekerja dalam tim, yaitu bukan dengan menugaskan semua pekerjaan pengkodean ke satu orang, tetapi didistribusikan kepada banyak pembuat kode sehingga memangkas waktu pemrosesan dan dapat mengatur tugas dengan lebih baik untuk memenuhi waktu pengiriman yang ditetapkan dalam jadwal studi. Terlepas dari volume dan kecepatan pemrosesan, masalah kedua yang kami amati dalam pengkodean manual adalah saat menetapkan teks ke beberapa kategori. Hal ini biasanya terjadi ketika berhadapan dengan teks opini yang luas, sehingga ada kemungkinan dua atau lebih kategori bukan hanya satu seperti yang diharapkan, jadi pembuat kode harus menetapkan teks opini ke beberapa kategori tertutup yang telah ditentukan sebelumnya, sehingga bukan menghasilkan variabel pilihan tunggal, tetapi variabel pilihan ganda yang pemrosesannya bisa agak lebih kompleks.

Masalah ketiga yang dihadapi selain yang telah disebutkan adalah apa yang harus dilakukan ketika teks yang kita koding berasal dari pertanyaan pilihan tunggal atau ganda. Misalnya, jika survei menanyakan "Apa rasa es krim favorit Anda?", maka pilihan jawabannya adalah COKLAT, MENTEGA, STROBERI DAN RASA LAINNYA. Saat kita mengklasifikasikan teks yang berasal dari jawaban RASA LAINNYA, di sana kita akan menemukan rasa seperti jeruk, asam jawa, kelapa, dll., Tetapi apa yang terjadi ketika kita membaca teks COKLAT HITAM? dalam hal ini kita harus menghapus teks itu dari database dan menambah jumlah pilihan COKLAT. Situasi ini adalah karma nyata bagi para pembuat kode, karena pekerjaan mereka harus dikoordinasikan dengan tim lapangan untuk melakukan koreksi pada database untuk menyelesaikan situasi ini.

PERANGKAT LUNAK DAN ALAT UNTUK MENGKLASIFIKASI (ATAU MENGKODE) SURVEI TEKS

Sejak akhir abad 70-an lalu, industri riset pasar telah memikirkan algoritma dan alat untuk melakukan kerja keras pengkodean teks terbuka dari survei dan mengubahnya menjadi kategori tertutup secara cepat, ramah, dan seefisien mungkin (semua ini dalam kerangka proyek riset opini publik yang dilakukan oleh firma riset pasar). Namun, saat ini saat sudah memasuki tahun 2020-an, hanya sedikit yang telah dicapai dalam hal ini, selain berbagai utilitas yang memungkinkan untuk mempercepat dan mengoptimalkan proses pengkodean. Namun, saat ini tugas pengkodean sebagian besar masih dilakukan secara manual atau semi-otomatis. Dengan demikian, alat SPSS telah menjadi salah satu dari sedikit perangkat lunak yang berani menawarkan opsi otomatis untuk mengklasifikasikan teks dalam jumlah besar dengan menggunakan algoritma untuk membangun pohon keputusan dan analisis klaster, serta teknik statistik lainnya yang telah digunakan sejak 1990-an untuk pembuatan taksonomi, analisis kelompok dan segmentasi pasar, dll melalui penerapan algoritma statistik tingkat lanjut.

The result generated by the SPSS Modeler Text Analytics application on a sample of 10,000 texts collected in an opinion survey is really poor when compared to the work done manually by a human, or at least that is the result we observed in the Spanish language. When the collected texts are in English, a better automatic coding could be obtained by means of this software, therefore some SPSS Text Analytics users opted to translate all the survey texts into English in bulk and from there they passed it to SPSS Text Analytics. The result of this process is that the automatic work is of poor quality, when compared to the manual work done by human coders. All this has led to companies continuing to use manual coding systems, but now with advanced aids such as RotatorSurvey's batch sorting to reduce work times and increase the efficiency and speed of manual work.

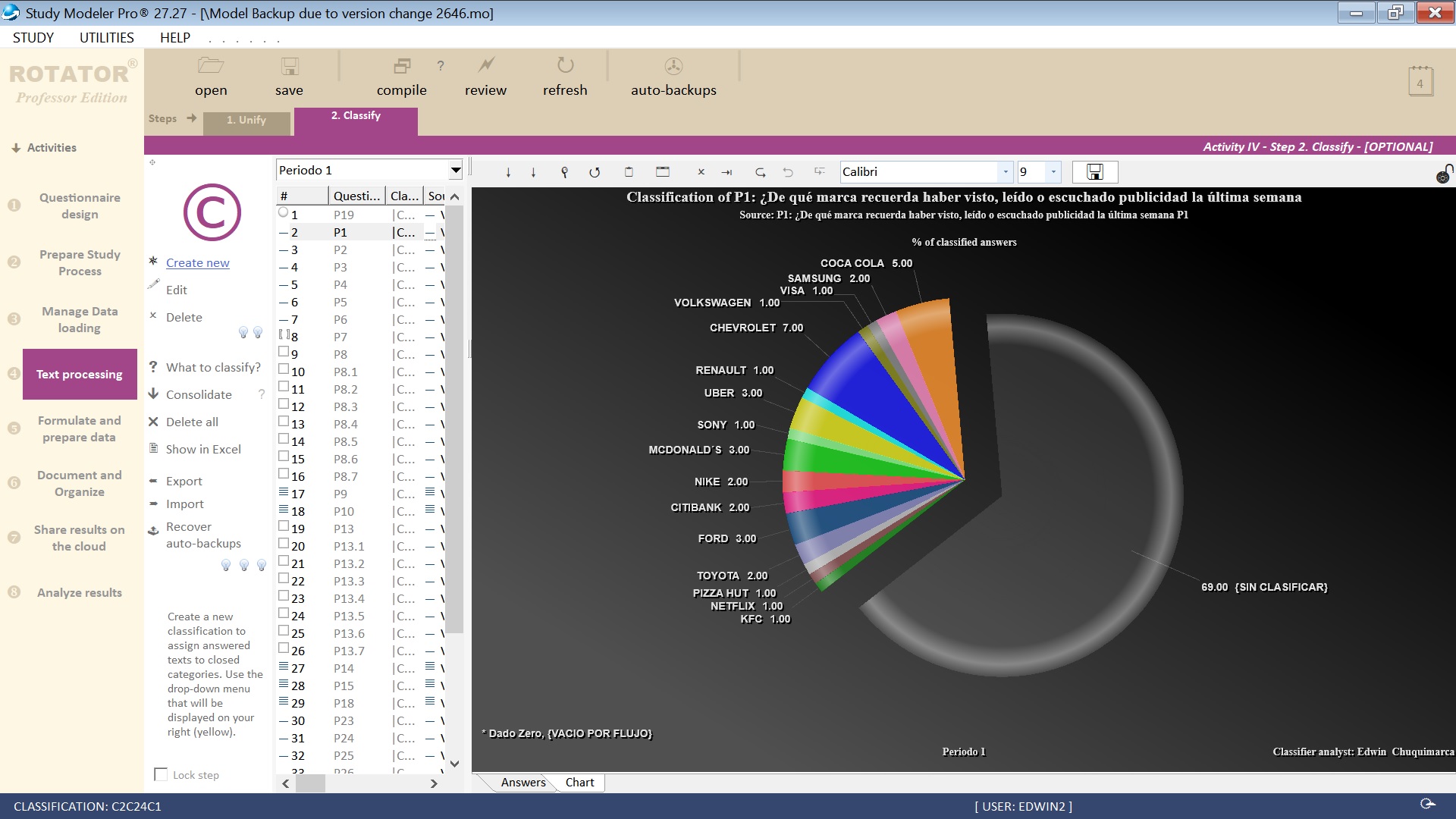

Tampilan layar modul Rotator Classifier pada tahun 2020

PENERAPAN KECERDASAN BUATAN PADA PENGOLAHAN TEKS SURVEI OPINI

Tahap selanjutnya yang akan kita lihat dalam dekade berikutnya adalah penerapan algoritme heuristik kecerdasan buatan (AI), yaitu perangkat cerdas yang mampu menganalisis konten tekstual dalam jumlah besar dalam hitungan detik, mempelajari logika manusia dan mengusulkan beberapa alternatif klasifikasi, semuanya dengan logika yang tak terbantahkan, serupa atau lebih tinggi dari keahlian manusia. Mengingat prospek yang menjanjikan ini, tugas pembuat kode akan dikurangi untuk melakukan tinjauan kualitas dan menyesuaikan parameter sistem, serta pelatihan sistem untuk mempelajarinya. Terlepas dari harapan ini dan kondisi seni kecerdasan buatan saat ini, kenyataannya adalah bahwa penggantian pikiran manusia untuk menutup pertanyaan terbuka dari sebuah survei, tidak akan mungkin dilakukan dalam jangka menengah atau panjang, alasannya adalah karena sistem kecerdasan buatan secara definisi, membutuhkan ribuan (atau jutaan) catatan data untuk pelatihan mandiri. Dan jika kita tidak memiliki penelitian besar sebelum penelitian kita, yang berisi semua variabilitas informasi yang diinginkan, kita akan memiliki kodifikasi penelitian yang buruk. Singkatnya, masih ada kesenjangan teknologi yang sangat besar untuk mendapatkan kategori otomatis tanpa atau dengan sedikit campur tangan manusia dan dengan interpretasi yang sempurna terhadap fenomena sosial-budaya yang biasanya dipelajari dalam survei.

Dokumen untuk diskusi lebih lanjut

Video: Pengantar Analisis Teks SPSS

Video: Menggunakan IBM SPSS Modeler dengan Text Analytics

Video: Masa Depan Analitik: Pembelajaran Mesin dan Analisis Data